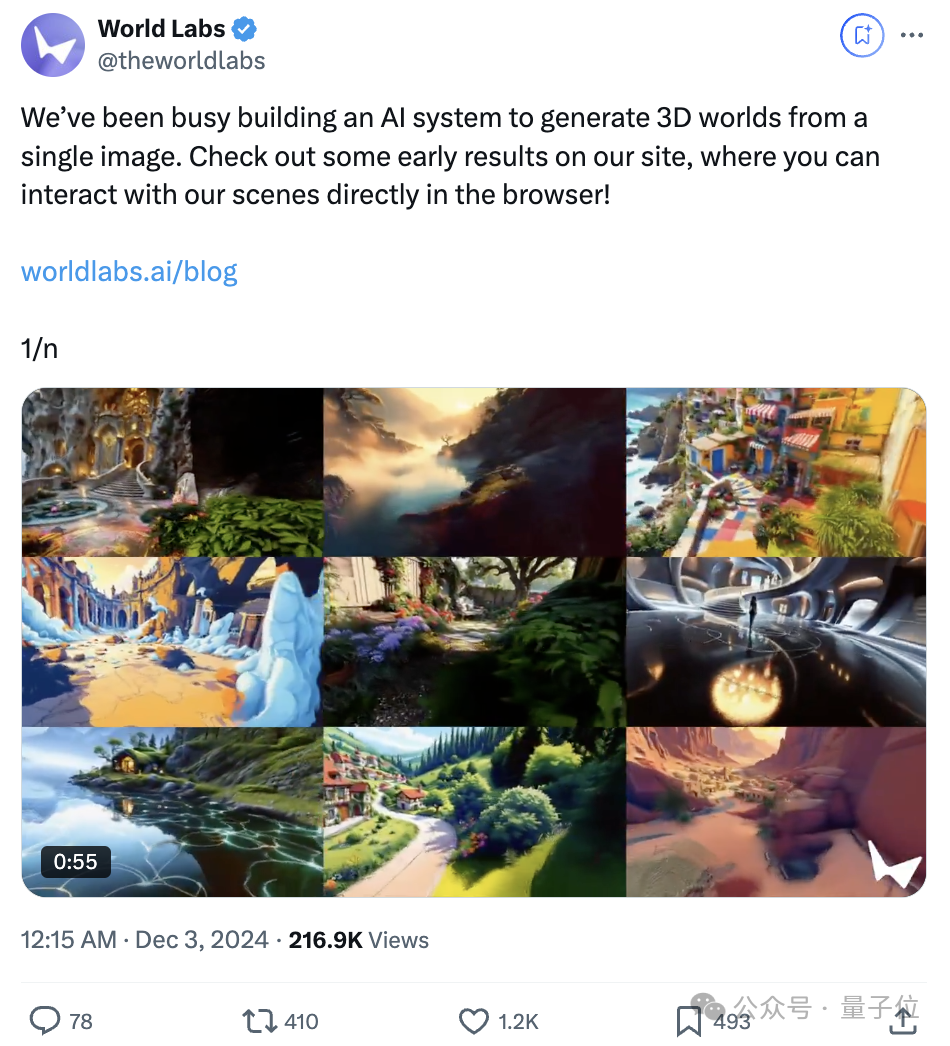

AI 靠单图生成 3D 世界:李飞飞空间智能首秀,可像玩游戏一样探索

就在刚刚,李飞飞空间智能首个项目突然发布:

仅凭借 1 张图,就能生成一个 3D 游戏世界的 AI 系统!

重点在于,生成的 3D 世界具有交互性。

能够像玩游戏那样,自由地移动相机来探索这个 3D 世界,浅景深、希区柯克变焦等操作均可行。

随便输入一张图:

除了这张图本体,可探索的 3D 世界里,所有东西都是 AI 生成的:

这些场景在浏览器中实时渲染,配备了可控的摄像机效果和可调节的模拟景深(DoF)。

你甚至可以改变其中物体颜色,动态调整背景光影,在场景中插入其他对象。

此外,之前大多数生成模型预测的是像素,而这个 AI 系统直接预测 3D 场景。

所以场景在你移开视线再回来时不会发生变化,并且遵循基本的 3D 几何物理规则。

网友们直接炸开锅,评论区“难以置信”一词直接刷屏。

其中不乏 Shopify 创始人 Tobi Lutke 等知名人士点赞:

还有不少网友认为这直接为 VR 打开了新世界。

官方则表示“这仅仅是 3D 原生生成 AI 未来的一个缩影”:

我们正在努力尽快将这项技术交到用户手中!

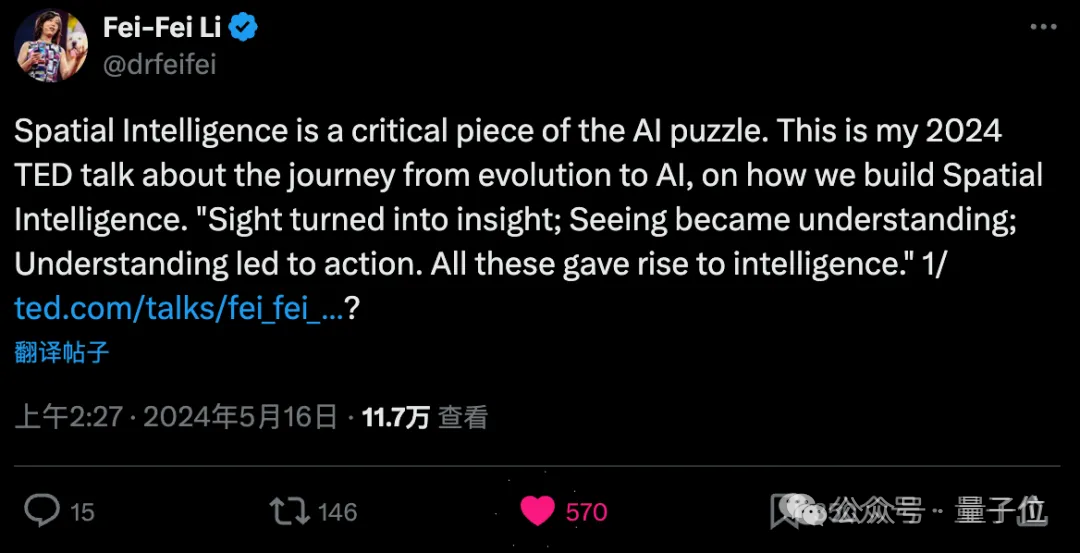

李飞飞本人也第一时间分享了这项成果并表示:

无论怎么理论化这个想法,用语言很难描述通过一张照片或一句话生成的 3D 场景互动的体验,希望大家喜欢。

目前候补名单申请已开启,有内容创作者已经用上了。羡慕的口水不争气地从眼角落了下来。

Beyond the input image

官方博文表示,今天,World labs 迈出了通往空间智能的第一步:

发布一个从单张图片生成 3D 世界的 AI 系统。

Beyond the input image, all is generated。

而且是输入任何图片。

而且是能够互动的 3D 世界 —— 用户可以通过 W / A / S / D 键来控制上下左右视角,或者用鼠标拖动画面来逛这个生成的世界。

官网博文中放了很多个可以试玩的 demo。

这次真的推荐大家都去试玩一下,上手体验和看视频 or 动图的感受非常的不一样。

好,问题来了,这个 AI 系统生成的 3D 世界还有什么值得探究的细节之处?

摄影机效果

World Labs 表示,一旦生成,这个 3D 世界就会在浏览器中实时渲染,给人的感觉跟在看一个虚拟摄像头似的。

而且,用户能够精准地控制这个摄像头。所谓“精准控制”,有 2 种玩法,

一是能够模拟景深效果,也就是只能清晰对焦距离相机一定距离的物体。

二是能模拟滑动变焦(Dolly Zoom),也就是电影拍摄技巧中非常经典的希区柯克变焦。

它的特点是“镜头中的主体大小不变,而背景大小改变”。

很多驴友去西藏、新疆玩儿的时候都希望用希区柯克变焦拍视频,有很强的视觉冲击力。在 World Labs 展示中,效果如下(不过在这个玩法里,没办法控制视角):

3D 效果

World Labs 表示,大多数生成模型预测的都是像素,与它们不同,咱这个 AI 预测的是 3D 场景。

官方博文罗列了三点好处:

第一,持久现实。

一旦生成一个世界,它就会一直存在。

不会因为你看向别的视角,再看回来,原视角的场景就会改变了。

第二,实时控制。

生成场景后,用户可以通过键盘或鼠标控制,实时在这个 3D 世界畅游移动。

你甚至可以仔细观察一朵花的细节,或者在某个地方暗中观察,用上帝视角注意这个世界的一举一动。

第三,遵循正确的几何规则。

这个 AI 系统生成的世界,是遵守 3D 集合物理基本规则的。

某些 AI 生成的视频,虽然效果很梦核,但可没有咱的这种深度的真实感哟(doge)。

官方博文中还写道,创造一个可视化 3D 场景,最简单的办法是绘制深度图。

图中每个像素的颜色,都是由它和摄像头的距离来决定的。

当然了,用户可以使用 3D 场景结构来构建互动效果 ——

单击就能与场景互了,包括但不限于突然给场景打个聚光灯。

动画效果?

那也是 so easy 啦。

走进绘画世界

团队还玩儿了一把,以“全新的方式”体验一些经典的艺术作品。

全新,不仅在于可互动的交互方式,还在于就靠输入进去的那一张图,就能补全原画里没有的部分。然后变成 3D 世界。

这是梵高的《夜晚露天咖啡座》:

这是爱德华・霍普的《夜行者》:

创造性的工作流

团队表示,3D 世界生成可以非常自然地和其它 AI 工具相结合。这让创作者们可以用他们已经用顺手的工具感受新的工作流体验。

举个栗子:

可以先用文生图模型,从文本世界来到图像世界。因为不同模型有各自擅长的风格特点,3D 世界可以把这些风格迁徙、继承过来。

在同一 prompt 下,输入不同风格的文生图模型生成的图片,可以诞生不同的 3D 世界:

一个充满活力的卡通风格青少年卧室,床上铺着五彩斑斓的毯子,桌子上杂乱地摆放着电脑,墙上挂着海报,散落着运动器材。一把吉他靠在墙上,中间铺着一块舒适的花纹地毯。窗户透进的光线给房间增添了一丝温暖和青春的气息。

World Labs 和空间智能

“World Labs”公司,由斯坦福大学教授、AI 教母李飞飞在今年 4 月创立。这也是她被曝出的首次创业。

而她的创业方向是一个新概念 —— 空间智能,即:

视觉化为洞察;看见成为理解;理解导致行动。

在李飞飞看来,这是“解决人工智能难题的关键拼图”。

只用了 3 个月时间,公司就突破了 10 亿美元估值,成为新晋独角兽。

公开资料显示,a16z、NEA 和 Radical Ventures 是领投方,Adobe、AMD、Databricks,以及老黄的英伟达也都在投资者之列。个人投资者中也不乏大佬:Karpathy、Jeff Dean、Hinton……

今年 5 月,李飞飞有一场公开的 15 分钟 TED 演讲。她洋洋洒洒,分享了对于空间智能的更多思考,要点包括:

视觉能力被认为引发了寒武纪大爆发 —— 一个动物物种大量进入化石记录的时期。最初是被动体验,简单让光线进入的定位,很快变得更加主动,神经系统开始进化…… 这些变化催生了智能。

多年来,我一直在说拍照和理解不是一回事。今天,我想再补充一点:仅仅看是不够的。看,是为了行动和学习。

如果我们想让 AI 超越当前能力,我们不仅想要能够看到和说话的 AI,我们还想要能够行动的 AI。空间智能的最新里程碑是,教计算机看到、学习、行动,并学习看到和行动得更好。

随着空间智能的加速进步,一个新时代在这个良性循环中正在我们眼前展开。这种循环正在催化机器人学习,这是任何需要理解和与 3D 世界互动的具身智能系统的关键组成部分。

据报道,该公司的目标客户包括视频游戏开发商和电影制片厂。除了互动场景之外,World Labs 还计划开发一些对艺术家、设计师、开发人员、电影制作人和工程师等专业人士有用的工具。

如今伴随着空间智能首个项目的发布,他们要做的事也逐渐具象化了起来。但 World Labs 表示,目前发布的只是一个“早期预览”:

我们正在努力改进我们生成的世界的规模和逼真度,并尝试新的方式让用户与之互动。

参考链接:

https://www.worldlabs.ai/blog

原标题《李飞飞空间智能首秀:AI 靠单图生成 3D 世界,可探索,遵循基本物理几何规则》